Từ trang Dave’s Garage

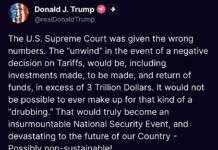

Hey, tôi là Dave, chào mừng bạn đến với cửa hàng của tôi. Tôi tên là Dave Plummer, một kỹ sư phần mềm đã nghỉ hưu tại Microsoft, làm việc từ thời MS-DOS và Windows 95. Hôm nay, chúng ta sẽ bàn về một cột mốc chấn động trong giới công nghệ: sự ra mắt của mô hình AI mã nguồn mở Deep Seek R1 của Trung Quốc.

Phát triển này được mô tả như một “Khoảnh khắc Sputnik” bởi Mark Andreessen, và điều đó không phải là nói quá. Cũng giống như việc phóng vệ tinh Sputnik từng thách thức sự tự tin về sức mạnh công nghệ của Mỹ trong thế kỷ 20, Deep Seek R1 đang buộc thế giới phải nhìn lại trong thế kỷ 21. Trước đây, nhiều người tin rằng cuộc đua giành vị trí dẫn đầu về AI nằm chắc trong tay những gã khổng lồ như OpenAI hay Anthropic. Nhưng với bước đột phá này, một đối thủ mới không chỉ xuất hiện mà còn vượt qua cả những kỳ vọng cao nhất.

Nếu bạn quan tâm đến tương lai của đổi mới AI và cuộc cạnh tranh công nghệ toàn cầu, bạn sẽ muốn hiểu Deep Seek R1 là gì, vì sao nó quan trọng, liệu có phải chỉ là trò lừa phóng đại, và nó ảnh hưởng thế giới ra sao.

Hãy đi sâu vào chi tiết. Điểm khiến cả ngành công nghiệp bị chấn động và làm giá cổ phiếu của những công ty như Nvidia và Microsoft lao đao nằm ở chỗ: Deep Seek R1 không những ngang ngửa hoặc vượt qua hiệu năng của các mô hình AI hàng đầu của Mỹ như OpenAI 0.1, mà còn được phát triển với chi phí rất thấp — theo báo cáo là dưới 6 triệu đô la. Khi so sánh với hàng chục tỉ, nếu không muốn nói là nhiều hơn, đã được đầu tư để đạt được những kết quả tương tự — chưa kể đến khoản thảo luận 500 tỉ đô la liên quan đến dự án Stargate — thì đây rõ ràng là một lời cảnh báo.

Bởi Trung Quốc không chỉ khẳng định họ làm với chi phí rẻ, mà còn được cho là không cần đến các chip mới nhất của Nvidia. Nếu đúng, điều này chẳng khác nào việc bạn có thể chế tạo một chiếc Ferrari trong garage từ phụ tùng của Chevrolet. Và nếu bạn có thể tự lắp một chiếc Ferrari chẳng khác gì xe “chính hãng”, bạn nghĩ điều đó sẽ tác động thế nào đến giá Ferrari trên thị trường?

Deep Seek R1 là gì? Đây là một mô hình ngôn ngữ mới được thiết kế để đạt hiệu suất “vượt tầm”, được huấn luyện ở quy mô nhỏ hơn nhưng vẫn có thể trả lời câu hỏi, sinh văn bản và nắm bắt bối cảnh. Điều làm nó nổi bật không chỉ là năng lực xử lý mà còn là cách nó được xây dựng — rẻ, hiệu quả, và đáng ngạc nhiên là rất linh hoạt. Deep Seek đã vận dụng các mô hình AI nền tảng quy mô lớn như OpenAI GPT-4 hay Meta LLaMA làm “khung sườn” (scaffolding) để tạo ra một thứ còn lớn hơn.

Hãy phân tích sâu hơn. Deep Seek R1 thực chất là một mô hình ngôn ngữ “distilled”. Khi bạn huấn luyện một mô hình AI khổng lồ, nó có thể có đến hàng trăm tỉ hoặc thậm chí cả ngàn tỉ tham số, tiêu thụ dữ liệu khổng lồ và cần cả một trung tâm dữ liệu GPU chỉ để vận hành. Nhưng đôi khi, bạn không cần tất cả sức mạnh đó để xử lý những tác vụ thông thường — đó là lúc “distillation” xuất hiện. Bạn dùng một mô hình lớn như GPT-4 (hoặc phiên bản khủng 671 tỉ tham số của Deep Seek) và dùng nó để “dạy” những mô hình nhỏ hơn.

Cách làm giống như một nghệ nhân bậc thầy truyền nghề cho một người học việc: bạn không cần người học việc phải nắm mọi thứ, chỉ cần họ đủ giỏi để làm tốt công việc. Deep Seek R1 đẩy cách tiếp cận này lên mức cao nhất bằng cách tận dụng những mô hình AI lớn hơn để dẫn dắt quá trình huấn luyện, nén gọn kiến thức và khả năng suy luận của những hệ thống đồ sộ thành một thứ nhỏ gọn và nhẹ hơn nhiều. Kết quả là bạn có một mô hình không đòi hỏi trung tâm dữ liệu khổng lồ để chạy — thậm chí có thể chạy trên CPU bình thường hoặc laptop, và đó là bước ngoặt lớn.

Vậy cụ thể nó hoạt động ra sao? Nó giống như dạy theo kiểu “học lỏm”: bạn có một mô hình lớn, biết hết về vật lý thiên văn, Shakespeare, và lập trình Python. Thay vì cố tái tạo sức mạnh xử lý khủng đó, Deep Seek R1 tập trung bắt chước đầu ra (output) của mô hình lớn trong nhiều dạng câu hỏi và tình huống. Bằng cách cẩn thận chọn ví dụ và lặp lại quá trình huấn luyện, bạn có thể dạy mô hình nhỏ sinh ra những câu trả lời tương tự mà không cần chứa toàn bộ lượng thông tin khổng lồ bên trong. Nó giống như chép được lời giải, nhưng không mang theo cả thư viện.

Điều thú vị hơn nữa là Deep Seek không chỉ dựa vào một mô hình lớn mà dùng nhiều AI khác nhau, bao gồm cả mô hình mã nguồn mở như Meta LLaMA, để tạo ra các góc nhìn đa dạng trong quá trình huấn luyện — như thể tập hợp cả một hội đồng chuyên gia để đào tạo cho một học viên xuất sắc. Kết hợp góc nhìn từ nhiều kiến trúc và bộ dữ liệu khác nhau, Deep Seek R1 có độ linh hoạt và thích nghi hiếm thấy trong một mô hình nhỏ gọn. Còn quá sớm để đưa ra nhiều kết luận, nhưng vì mô hình này là mã nguồn mở, mọi thiên kiến (bias) hay bộ lọc tích hợp đều có thể được tìm thấy trong các tham số công khai. Nói cách khác, rất khó để che giấu những thứ đó khi mô hình được mở mã nguồn.

Trên thực tế, một trong những thử nghiệm đầu tiên của tôi là hỏi Deep Seek về bức ảnh nổi tiếng chụp một người đàn ông đứng chặn trước đoàn xe tăng. Mô hình trả lời chính xác: đó là sự kiện Thiên An Môn, giải thích ý nghĩa của tấm ảnh, tên nhiếp ảnh gia, và cả những vấn đề kiểm duyệt xung quanh nó. Tất nhiên, phiên bản Deep Seek trực tuyến ở Trung Quốc có thể khác, vì tôi đang chạy phiên bản ngoại tuyến. Nhưng bản công khai có thể tải xuống dường như rất đáng tin cậy.

Vì sao tất cả những điều này quan trọng? Thứ nhất, nó hạ thấp đáng kể rào cản tiếp cận AI. Thay vì cần cơ sở hạ tầng khổng lồ hay nguồn năng lượng hạt nhân riêng để triển khai một mô hình ngôn ngữ lớn, giờ đây bạn có thể chỉ cần một hệ thống nhỏ hơn nhiều. Đó là tin tốt cho các công ty nhỏ, phòng thí nghiệm nghiên cứu, hoặc thậm chí những người đam mê AI muốn khám phá mà không tốn quá nhiều chi phí.

Thực tế là tôi đang chạy mô hình này trên AMD Threadripper, kèm với GPU Nvidia RTX 6000 48GB và có thể vận hành phiên bản lớn nhất 671 tỉ tham số với tốc độ sinh hơn 4 token mỗi giây. Phiên bản 32 tỉ tham số thì chạy “ngon” trên MacBook Pro của tôi.

Tiếp theo, các phiên bản nhỏ hơn của Deep Seek thậm chí có thể chạy trên Orin Nano giá khoảng 249 đô la. Nhưng cũng có một vài điểm cần lưu ý. Việc xây dựng một hệ thống với chi phí thấp luôn tiềm ẩn rủi ro. Trước tiên, mô hình nhỏ thường gặp khó khăn khi phải bao quát phạm vi kiến thức rộng như các mô hình lớn, dễ rơi vào tình trạng “ảo giác” (hallucinations), tức là đưa ra những câu trả lời nghe có vẻ rất tự tin nhưng lại sai. Chúng cũng có thể không hoạt động tối ưu với những câu hỏi đòi hỏi tính chuyên sâu hoặc phân tích tinh vi.

Ngoài ra, vì các mô hình nhỏ này dựa vào dữ liệu huấn luyện từ các mô hình lớn, chất lượng của chúng phụ thuộc rất nhiều vào “người thầy”. Nghĩa là nếu mô hình lớn có sai sót hay thiên kiến nào, thì mô hình nhỏ huấn luyện từ đó cũng sẽ “thừa hưởng” những vấn đề tương tự.

Còn về khả năng mở rộng, hiệu suất của Deep Seek rất ấn tượng, nhưng cũng cần nhớ rằng việc tập trung vào tối ưu chi phí và khả năng tiếp cận rộng rãi đồng nghĩa với việc Deep Seek R1 có thể sẽ không cạnh tranh trực tiếp với những mô hình AI khổng lồ về mặt khả năng tiên tiến nhất. Thay vào đó, nó tìm được vị trí riêng, đóng vai trò như một giải pháp AI thiết thực và tiết kiệm chi phí. Cách tiếp cận này gợi nhớ đến thời kỳ đầu của máy tính cá nhân (PC). Lúc ấy, ngành công nghiệp bị thống trị bởi các máy mainframe khổng lồ, rồi xuất hiện những chiếc PC nhỏ gọn, tuy không làm được mọi thứ nhưng “đủ tốt” cho rất nhiều tác vụ. Vài thập kỷ sau, PC đã làm thay đổi hoàn toàn lĩnh vực điện toán.

Deep Seek có thể chưa phải GPT-5, nhưng nó mở đường cho một bối cảnh AI “dân chủ hóa” hơn, nơi công nghệ cao cấp không chỉ gói gọn trong tay một số ít đại gia.

Hệ quả của điều này rất lớn. Hãy hình dung những mô hình AI được “may đo” riêng cho từng ngành, có thể chạy tại chỗ (on-premise) để đảm bảo tính riêng tư và quyền kiểm soát, hoặc thậm chí được cài đặt vào điện thoại thông minh hay thiết bị gia dụng. Ý tưởng về một trợ lý AI cá nhân—không nhất thiết dựa vào hạ tầng đám mây khổng lồ—trở nên khả thi hơn bao giờ hết.

Tất nhiên, con đường phía trước sẽ không ít thử thách. Deep Seek và các mô hình tương tự cần chứng minh chúng có thể xử lý tốt các tình huống thực tế, có khả năng mở rộng và tiếp tục đổi mới trong một lĩnh vực vốn đang bị những “ông lớn” thống trị.

Nhưng bài học từ lịch sử công nghệ cho thấy, không phải lúc nào đổi mới cũng đến từ những người khổng lồ. Đôi khi, chỉ cần một góc nhìn mới và sự quyết tâm—hay đôi khi là “buộc phải” làm khác đi—cũng đủ để tạo nên đột phá.

Deep Seek R1 cho thấy Trung Quốc không chỉ là người tham gia đơn thuần trong cuộc đua AI toàn cầu, mà là một đối thủ đáng gờm có khả năng tạo ra những mô hình nguồn mở tiên tiến. Đối với các công ty AI của Mỹ như OpenAI, Google DeepMind và Anthropic, điều này là thách thức kép: vừa phải duy trì vị thế dẫn đầu công nghệ, vừa phải lý giải vì sao mức giá (hay chi phí) cao của họ vẫn xứng đáng trong bối cảnh xuất hiện ngày càng nhiều giải pháp cạnh tranh hợp lý về chi phí.

Vậy tác động lên AI Mỹ là gì? Các mô hình mở như Deep Seek R1 cho phép nhà phát triển trên toàn thế giới sáng tạo với chi phí thấp hơn, có thể làm giảm lợi thế cạnh tranh của các mô hình độc quyền, nhất là trong nghiên cứu và ứng dụng tại các doanh nghiệp vừa và nhỏ. Với các công ty Mỹ dựa vào doanh thu từ dịch vụ đăng ký (subscription) hoặc cung cấp API, áp lực cạnh tranh sẽ tăng lên, và không ít nhà đầu tư có thể bớt “nhiệt tình”.

Việc Deep Seek R1 phát hành dưới dạng mã nguồn mở cũng “dân chủ hóa” quyền truy cập vào AI, cho phép các doanh nghiệp và chính phủ toàn cầu xây dựng dựa trên mô hình này, mà không phải lo về giấy phép hay những hạn chế do công ty Mỹ áp đặt.

Điều đó thúc đẩy tốc độ ứng dụng AI trên khắp thế giới, nhưng cũng có thể làm giảm nhu cầu với những mô hình phát triển tại Mỹ, ảnh hưởng đến nguồn doanh thu của các hãng như OpenAI hoặc Google Cloud. Trên thị trường chứng khoán, những công ty phụ thuộc nhiều vào việc bán giấy phép công nghệ AI, hạ tầng đám mây, chip của Nvidia hoặc tích hợp API có thể sẽ bị ảnh hưởng khi nhà đầu tư điều chỉnh dự báo tăng trưởng.

Ngay phần đầu, tôi có nhắc đến giả thuyết “thuyết âm mưu” cho rằng có lẽ không nên hoàn toàn tin Trung Quốc về con số chi phí thấp và phần cứng “hạng hai”. Nếu thật sự có đầu tư lớn của nhà nước đứng sau, đây có thể là nỗ lực gây biến động thị trường Mỹ bằng cách tỏ ra làm AI “rẻ như cho” trong khi thực chất đã được bơm tiền khủng. Dù thế nào, cũng phải chờ thời gian trả lời.

Tóm lại, Deep Seek R1 là một mô hình AI nhỏ gọn nhưng “đấm” mạnh hơn trọng lượng của nó, được xây dựng với nhiều kỹ thuật thông minh nhằm đưa công nghệ AI tiên tiến đến gần hơn với nhiều người. Nó không hoàn hảo, cũng không cố gắng trở thành hoàn hảo, nhưng lại cho chúng ta cái nhìn thú vị về tương lai AI: nhẹ hơn, tiết kiệm hơn, hơi thô ráp, nhưng tiềm năng vô cùng lớn.

Cảm ơn bạn đã lắng nghe!