Một số nhà nghiên cứu cấp cao vừa từ chức khỏi hai trong số các tổ chức AI lớn nhất thế giới: Anthropic và OpenAI. Trong đó, một nhà nghiên cứu rời Anthropic đã đăng tải một lời cảnh báo mạnh mẽ rằng:

📍 “Toàn cầu đang gặp nguy hiểm trước hàng loạt khủng hoảng, và AI là một trong những mối đe dọa lớn”.

Đây không chỉ là chuyện “người này nghỉ việc”, mà là tín hiệu từ bên trong ngành về những lo ngại sâu sắc liên quan tới trí tuệ nhân tạo.

Tóm tắt sự việc

- Các nhà nghiên cứu rời khỏi Anthropic và OpenAI

- Họ đều là người từng tham gia ở vị trí rất cao trong lĩnh vực AI.

- Quyết định nghỉ việc được đưa ra trong bối cảnh tranh luận ngày càng gay gắt về quy định, trách nhiệm và rủi ro của công nghệ AI.

- Một người trong số đó cảnh báo rằng:

- Thế giới đang đối mặt với “nhiều khủng hoảng” có thể đe dọa an nguy loài người.

- AI, nếu phát triển không có kiểm soát hoặc không được điều chỉnh bởi luật pháp, có thể gây ra hậu quả tồi tệ.

- Bối cảnh rộng hơn:

- AI đã bước vào cuộc sống hàng ngày với tốc độ chưa từng có: chatbots, công cụ tạo nội dung, mô hình ngôn ngữ lớn (LLM) như ChatGPT…

- Những công nghệ này mở ra lợi ích lớn nhưng cũng đồng thời tạo ra:

- rủi ro về an ninh mạng,

- lạm dụng thông tin,

- sai lệch dữ liệu,

- tác động tới lao động – việc làm,

- và – theo một số chuyên gia – các nguy cơ lớn hơn nếu các hệ thống càng lúc càng mạnh.

Bình luận: Vì sao chuyện này quan trọng?

🔹 1. Đây là tiếng nói từ trong ngành

Khi các nhà nghiên cứu “từ bỏ tiền đồ” trong những tổ chức hàng đầu, và thậm chí công khai lo ngại, đó không phải chuyện bình thường. Điều đó phản ánh:

- Những mâu thuẫn nội bộ về hướng phát triển.

- Lo ngại về mức độ an toàn và đạo đức của AI.

- Cảm giác “không còn tiếng nói” trong quyết định chiến lược.

🔹 2. AI không chỉ là kỹ thuật — mà là hệ quả xã hội

Với AI ngày càng mạnh mẽ:

- AI có thể tự nhân rộng, tự học từ dữ liệu khổng lồ.

- AI có thể tạo nội dung giống người thật (deepfake, chatbot cực thông minh).

- AI có thể được dùng cho mục đích nguyên thủy (tốt) hoặc nguy hiểm (xuyên tạc, gây hỗn loạn).

Một số nhà nghiên cứu tin rằng hệ thống AI thế hệ mới có thể vượt khỏi tầm kiểm soát nếu không được điều tiết.

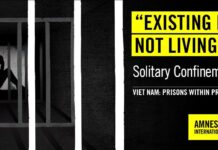

🔹 3. Sự thiếu khung pháp lý đang gây căng thẳng

Cho đến nay, hầu như các quốc gia đều đang loay hoay xây luật để điều chỉnh AI – nhưng tiến độ còn chậm so với tốc độ phát triển của công nghệ.

Việc những chuyên gia nội bộ “nộp đơn ra đi kèm cảnh báo” là một trong những dấu hiệu cho thấy:

- ngành công nghệ đang cảm thấy “hệ thống hiện tại không an toàn”;

- và xã hội rộng lớn hơn vẫn chưa có đủ luật để kiểm soát AI một cách nghiêm túc.

Kết luận

Sự ra đi của các nhà nghiên cứu tại Anthropic và OpenAI cùng những lời cảnh báo liên quan không chỉ là một tin nghề nghiệp – đó là cảnh báo sớm từ bên trong ngành về những rủi ro lớn hơn mà AI có thể gây ra nếu không được quản lý đúng đắn.

Câu hỏi đặt ra cho chúng ta – cả xã hội, nhà lập pháp, giới khoa học, và người sử dụng cuối cùng là:

🔹 Chúng ta có đủ hiểu biết và kiểm soát để phát triển AI một cách an toàn không?

🔹 Trách nhiệm thuộc về ai? Chính phủ? Các công ty? Xã hội?

Đây là câu chuyện không chỉ của thế giới công nghệ, mà là của cả nhân loại trong thời đại số.